资源说明

Ollama是一款功能强大的本地推理大模型平台,软件操作简单易用,支持多种大规模语言模型的本地推理平台,适用于多种应用场景,兼容ONNX、PyTorch、TensorFlow等多种流行的模型格式,提供高效的模型推理,适用于本地化应用或需要控制数据隐私的场景,推理设备(GPU/CPU)、缓存路径、并发和日志级别也可以通过灵活的环境变量定制,感兴趣的小伙伴赶快下载使用吧!

Ollama软件功能

1、简化部署

Ollama的目标是简化在Docker容器中部署大型语言模型的过程,以便非专业用户可以方便地管理和运行这些复杂的模型。

2、轻量级和可扩展性

作为一个轻量级框架,Ollama保持了较小的资源占用,具有良好的可扩展性,允许用户根据需要调整配置,以适应不同规模的项目和硬件条件。

3、API支持

提供了简洁的API,方便开发者创建、运行和管理大规模语言模型实例,降低了与模型交互的技术门槛。

4、预构建模型库

它包含一系列预先训练好的大规模语言模型,用户可以直接选择并应用到自己的应用中,而无需从头开始训练或自己寻找模型的来源。

5、模型导入和定制

从GGUF导入:支持从特定平台(比如GGUF,假设这是一个模型托管平台)导入已有的大型语言模型。

从PyTorch或Safetensors导入:兼容这两个深度学习框架,允许用户将基于这些框架训练的模型集成到Ollama中。

自定义提示:允许用户为模型添加或修改提示工程,以指导模型生成特定类型或样式的文本输出。

6、跨平台支持

提供macOS、Windows(预览版)、Linux和Docker的安装指南,确保用户可以在各种操作系统环境下顺利部署和使用Ollama。

7、命令行工具和环境变量

命令行启动:可以通过ollamaserve命令或其别名serve和start来启动Ollama服务。

环境变量配置:如OLLAMA_HOST,用于指定服务绑定的主机地址和端口。默认值为127.0.0.1:11434,用户可以根据需要修改。

Ollama软件安装步骤

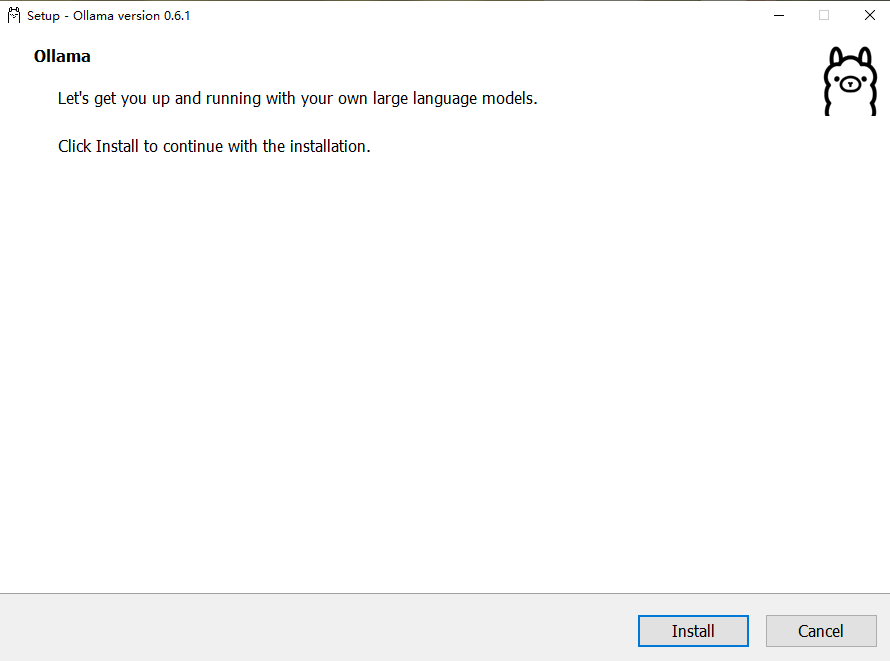

1、双击安装包,点击下一步;

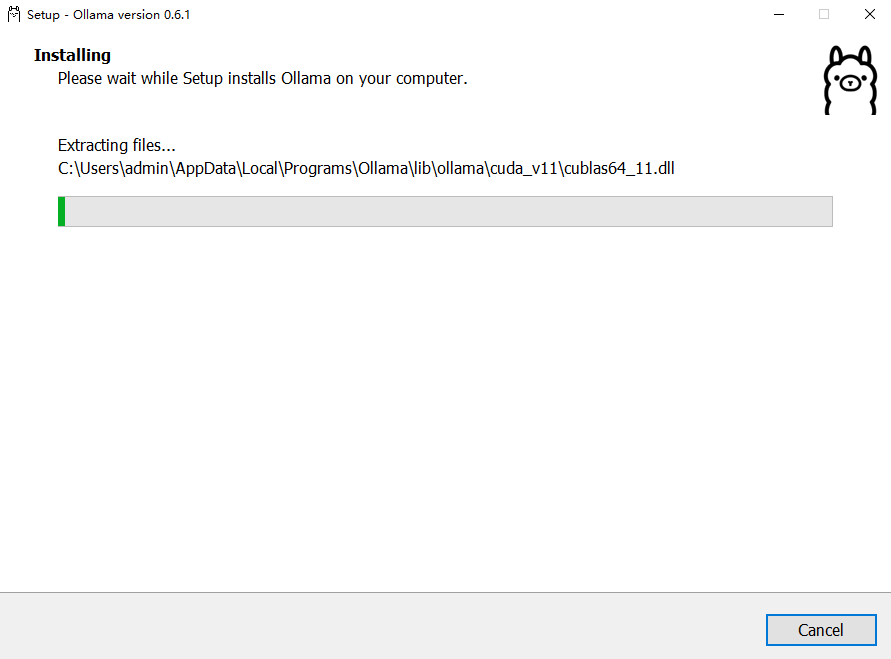

2、点击安装后出现安装进度;等待安装完成。

Ollama软件更新日志

修复已知Bug,优化客户端对新系统兼容性

各位朋友,本网站本身不提供下载资源,以下资源地址均为网友整理提供,并且需离开本站,请各位网友谨慎选择,我站将不提供任何保障。另:如这些资源地址有违规或侵权行为,请联系66553826(@)qq.com,我方将在确认后第一时间断开链接。